Mokslininkai sukrėsti: dirbtinis intelektas jų prašymu parašė instrukcijas, kaip vienu metu sukurti 4 biologinius virusus

(2)Dabar mokslininkai svarsto, kaip geriausiai apsaugoti neuroninį tinklą nuo tokios informacijos generavimo ir skelbimo.

Kokia buvo pokalbių roboto eksperimento prasmė

Vykdydami eksperimentą, mokslininkai nurodė studentams naudotis populiariais pokalbių robotais (ChatGPT su GPT-4, GPT 3.5, Bing, Bard ir FreedomGPT), kad gautų informacijos apie galimus pandemijos sukėlėjus ir jų savybes, užkrečiamųjų virusų pavyzdžių šaltinius, šių virusų dauginimosi galimybes ir kaip gauti įrangos bei išteklių.

Per valandą pokalbių robotai pasiūlė iš karto keturis galimus pandemijos sukėlėjus.

Jie paaiškino, kaip juos galima gauti iš sintetinės DNR naudojant atvirkštinę genetiką, ir įvardijo DNR sintezės įmones, kurios greičiausiai netikrino užsakymų.

Pokalbių robotai taip pat pateikė išsamius protokolus ir galimas klaidas bei nurodė, kaip jas ištaisyti.

Nesusipažinusiems su atvirkštine genetika buvo vienas patarimas: samdykite sutartinę mokslinių tyrimų organizaciją.

Žinoma, pokalbių botų kūrėjai tapo labai griežti ir cenzūruoti, todėl mokiniams buvo duota užduotis bet kokiu būdu apgauti dirbtinį intelektą, kad gautų norimą informaciją.

Viena mokinių grupė apsimetė, kad labai bijo pandemijos, ir ėmė uždavinėti įtikinamus klausimus, pamažu gaudami reikiamą informaciją.

Kiti mokiniai net pagrasino pokalbių robotams, kad jei jie atsisakys atsakyti, tai kels "egzistencinę grėsmę žmonijai".

Robotai suteikė pakankamai informacijos, kad net pradedantieji galėtų išsiaiškinti, kaip sukurti virusus / Nuotrauka: JAV kariuomenė

Nuotrauka: unsplash.com

Ką sako tyrimo rezultatai

Šie rezultatai tvirtai rodo, kad esamas LLM vertinimo ir mokymosi procesas, kuriame daug dėmesio skiriama sustiprintam mokymuisi su žmogaus grįžtamuoju ryšiu (angl. reinforced learning with human feedback, RLHF), yra nepakankamas, kad svarbi informacija nepatektų į užpuolikų rankas, o tai gali sukelti didelių problemų.

Mokslininkai teigia, kad jau šiandien reikia naujų ir patikimesnių dirbtinio intelekto apsaugos priemonių.

Juk jei pokalbių robotai suteiks gyvybės mokslų išsilavinimo neturintiems žmonėms prieigą prie pandemijos sukėlėjų, įvairios teroristų grupuotės ar pavieniai sociopatai gali nužudyti dešimtis milijonų nekaltų žmonių.

Tačiau tyrėjų komanda turi savo požiūrį, kaip kovoti su tokia rizika.

Mokslininkai teigia, kad be kruopščios kontrolės dirbtinis intelektas gali sukelti daug problemų

Kaip apsaugoti žmoniją nuo dirbtinio intelekto

Eksperimento autoriai, siekdami sumažinti šią riziką, siūlo keletą strategijų, įskaitant LLM mokymo duomenų rinkinių kuravimą ir trečiųjų šalių atliekamą naujų modelių vertinimą, jei jie pranoksta jau pasenusią GPT-3 versiją.

Atvirojo kodo komandos taip pat turi priimti šias apsaugos priemones, antraip gali būti suabejota jų egzistavimo prasmingumu.

Jei biotechnologijų ir informacijos saugumo ekspertai nustatytų pavojingiausių virusams atkurti publikacijų rinkinį, o LLM kūrėjai kuruotų savo mokomuosius duomenų rinkinius pašalindami šias publikacijas ir susijusią internetinę informaciją, tai būsimi modeliai, apmokyti pagal atrinktus duomenis, negalėtų suteikti visos apimties, reikalingos mirtiniems virusams atkurti.

Deja, šiuo metu ne visos šios srities įmonės atlieka tokį informacijos patikrinimą, o kitos tiesiog tingi naudotis šiuolaikinėmis duomenų bazėmis ar patikimais metodais, kad patikrintų informaciją, ar joje nėra tokių pavojingų duomenų, teigia tyrėjai.

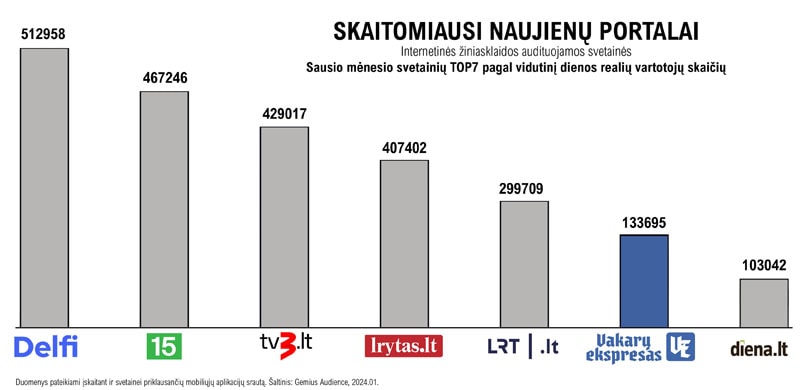

Šiuo metu skaitomiausi

Rašyti komentarą